Guidelines & Standards

Evidence 2016;8(1): e1000129 doi: 10.4470/E1000129

Pubblicato: 26 gennaio 2016

Copyright: © 2016 Bossuyt et al. Questo è un articolo open-access, distribuito con licenza Creative Commons Attribution, che ne consente l’utilizzo, la distribuzione e la riproduzione su qualsiasi supporto esclusivamente per fini non commerciali, a condizione di riportare sempre autore e citazione originale.

Una delle principali fonti evitabili di spreco nella ricerca biomedica è costituita dal reporting incompleto degli studi che spesso non forniscono le informazioni necessarie per la loro identificazione, valutazione critica e riproducibilità. Per migliorare la qualità dei report degli studi di accuratezza diagnostica è stato sviluppato lo statement sugli standard per il reporting degli studi di accuratezza diagnostica: Standards for Reporting Diagnostic Accuracy (STARD). Questo articolo presenta la versione 2015 di STARD, lista aggiornata di 30 item essenziali che dovrebbero essere inseriti in tutti i report degli studi di accuratezza diagnostica. L’aggiornamento comprende recenti evidenze su fonti di bias e variabilità nell’accuratezza diagnostica e ha lo scopo di facilitare l’utilizzo di STARD. STARD 2015 può contribuire a migliorare completezza e trasparenza nel reporting degli studi di accuratezza diagnostica.

I ricercatori discutono e scrivono dei propri studi, non solo perchè soddisfatti o meno dei risultati ottenuti, ma anche per consentire di comprenderne la validità dei metodi, permettere ai colleghi di replicarli e per rendere noti i risultati a medici, altri professionisti sanitari e decisori, le cui decisioni vengono guidate da evidenze metodologicamente robuste.

Purtroppo in molte aree della medicina sono state evidenziate carenze nel reporting della ricerca (1). Elementi essenziali dei metodi vengono spesso descritti in maniera inadeguata e talvolta del tutto omessi, rendendo difficile se non impossibile sia la valutazione critica che la possibilità di ripetere lo studio. I risultati vengono a volte riportati in modo selettivo, oppure interpretati con ingiustificato ottimismo (2-4). Questi comportamenti riducono il valore degli studi primari e condizionano negativamente quelli secondari, quali revisioni sistematiche e linee guida.

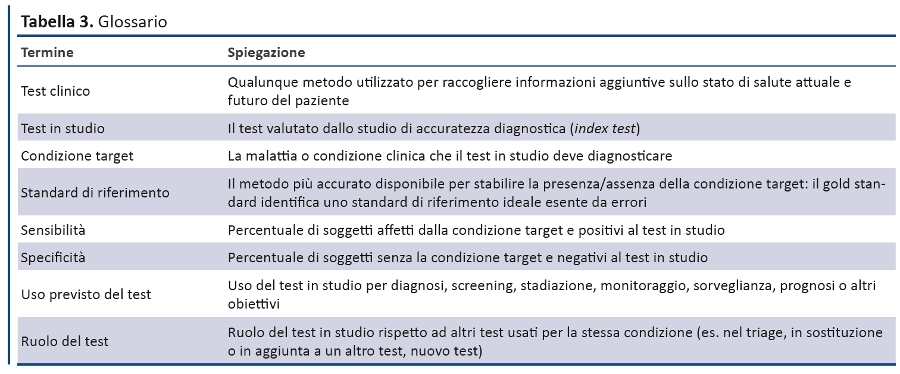

I report degli studi che valutano l’accuratezza dei test diagnostici non costituiscono eccezione: infatti, un numero crescente di valutazioni ha identificato numerose carenze nel loro reporting (5). Si tratta di studi dove un test diagnostico viene valutato rispetto ad uno standard di riferimento clinico, o gold standard; i risultati sono in genere riportati come stime di sensibilità e specificità del test, che esprimono l’accuratezza del test nell’identificare correttamente i pazienti con la condizione target. Altre misure utilizzate sono la curva ROC (Receiver Operating Characteristics) e i valori predittivi, positivo e negativo.

Nonostante la loro apparente semplicità, questi studi sono a rischio di bias (6,7). Ad esempio, se nell’analisi finale non vengono inclusi tutti i pazienti sottoposti al test in studio, oppure se vengono inclusi solo i controlli sani, le stime di accuratezza del test possono non riflettere la sua reale performance nelle applicazioni cliniche. Eppure spesso i report degli studi non contengono queste informazioni fondamentali.

È oggi ben documentato che sensibilità e specificità non sono caratteristiche fisse di un test diagnostico: infatti, i risultati falsi positivi e falsi negativi variano in relazione al contesto, alle modalità di selezione dei pazienti e ai test diagnostici a cui sono già stati sottoposti. Purtroppo molti autori non forniscono nel report dello studio adeguati dettagli su contesto clinico, tempo, luogo e modalità con cui sono stati identificati e reclutati i partecipanti eleggibili (8). Inoltre, le stime di sensibilità e specificità possono differire a causa della variabilità delle definizioni dello standard di riferimento con cui viene confrontato il test in studio. Pertanto, queste informazioni dovrebbero essere disponibili nel report dello studio.

Lo STARD Statement 2003

Per migliorare completezza e trasparenza dei report sugli studi di accuratezza diagnostica, un gruppo di ricercatori, direttori di riviste e altri stakeholders ha sviluppato una lista di item fondamentali che dovrebbero essere inclusi nel report di ogni studio. Il principio guida per lo sviluppo della checklist è stato quello di selezionare gli elementi che, se descritti, aiuterebbero il lettore a giudicare il rischio di bias dello studio e valutare l’applicabilità dei risultati e la validità di conclusioni e raccomandazioni degli autori.

Nel 2003 è stato pubblicato in 24 riviste scientifiche lo statement relativo agli standard per il reporting degli studi di accuratezza diagnostica — Standards for Reporting Diagnostic Accuracy (STARD) (9). Lo statement è stato accompagnato da editoriali e commenti in numerose pubblicazioni e sostenuto da molte altre riviste. Dopo la pubblicazione dello STARD alcune valutazioni hanno evidenziato miglioramenti piccoli, ma statisticamente significativi, nel reporting degli studi di accuratezza diagnostica [guadagno medio 1.4 item (IC 95% 0.7-2.2)] (5,10). Progressivamente i report degli studi hanno iniziato ad includere un numero maggiore di item della checklist, ma la situazione è ancora lontana da quella ottimale.

Metodi per lo sviluppo dello STARD 2015

Nel 2013 il comitato direttivo STARD, che rivede periodicamente la letteratura per selezionare studi potenzialmente rilevanti ha deciso che era il momento di aggiornare la checklist con due obiettivi principali: 1. integrare le recenti evidenze su fonti di bias, problemi di applicabilità e identificazione dei fattori che inducono a interpretazioni “generose” degli studi di accuratezza dei test diagnostici; 2. semplificare l’uso della checklist. L’aggiornamento ha tenuto in considerazione la necessità di armonizzazione STARD con altre linee guida per il reporting, quali il CONSORT 2010 (11).

Una descrizione completa del processo di aggiornamento e del razionale delle modifiche sono disponibili sul sito EQUATOR - Enhancing the Quality and Transparency of Health Research (www.equator-network.org/reporting-guidelines/stard). In sintesi, i membri del gruppo STARD 2003 sono stati invitati a partecipare al processo di aggiornamento, a identificare nuovi membri e a commentare gli obiettivi generali dell’aggiornamento. Il gruppo STARD oggi ha raggiunto 85 membri che comprendono ricercatori, direttori di riviste, giornalisti, esperti nella sintesi delle evidenze, finanziatori e altri stakeholders.

I membri del gruppo STARD hanno suggerito e, quindi, approvato le proposte di aggiornamento attraverso una survey via web in due round. Questo ha permesso di definire una bozza della lista degli item principali, discussa dal comitato direttivo in un meeting di due giorni tenutosi ad Amsterdam nel settembre 2014. La lista è stata quindi sottoposta a un test pilota da parte di ricercatori junior e senior, revisori e direttori di riviste.

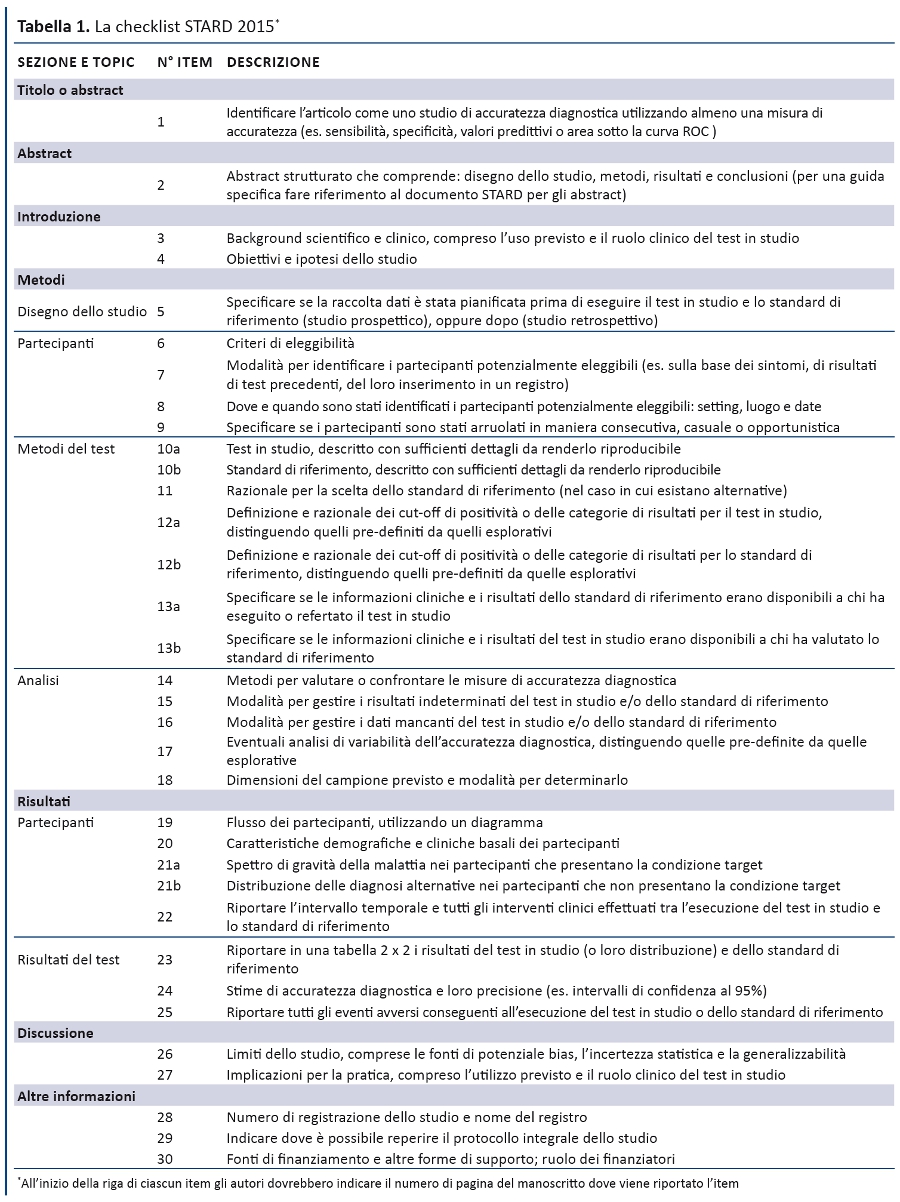

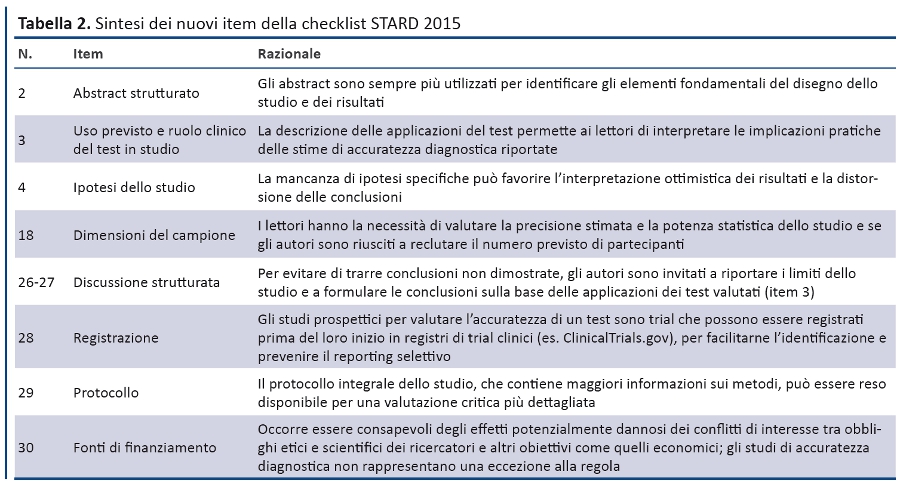

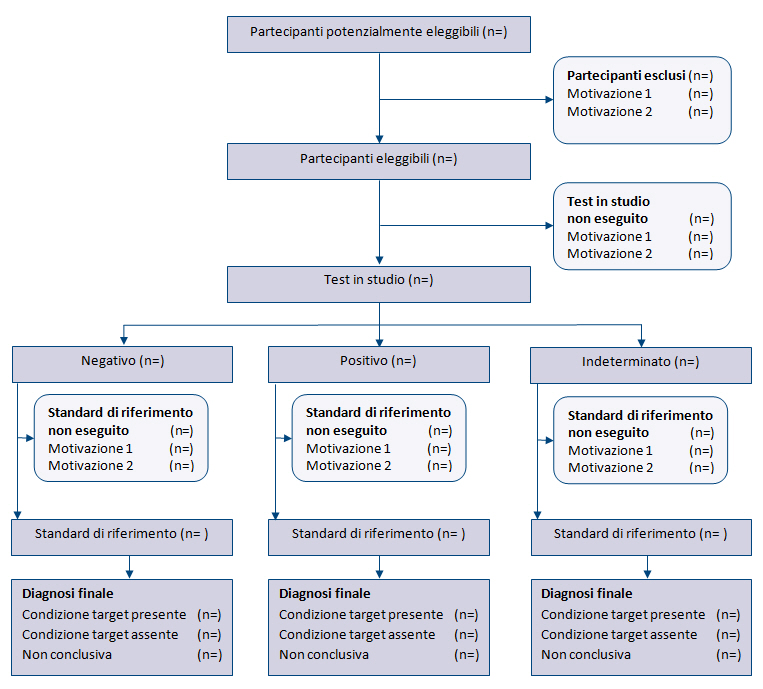

La struttura generale di STARD 2015 è simile a quella di STARD 2003. La checklist (tabella 1) riporta i 30 item, raggruppati in sezioni coerenti con la struttura IMRaD degli articoli scientifici (Introduzione, Metodi, Risultati, Discussione). Numerosi item sono identici a quelli della versione 2003, mentre altri sono stati riformulati, combinati o suddivisi se complessi. La tabella 2 descrive i nuovi item e la tabella 3 elenca le parole chiave. Un diagramma per descrivere il flusso di partecipanti è ora previsto in tutti i report (figura).

Scopo

STARD 2015 sostituisce integralmente la versione del 2003: pertanto chi vuole fare riferimento a STARD è invitato a citare questo articolo. La checklist rappresenta un set minimo di item, ma il report di uno studio generalmente richiede un numero maggiore di informazioni. In ogni caso, un report adeguato di uno studio di accuratezza diagnostica deve comprendere tutti gli item applicabili.

Gli autori sono invitati ad utilizzare STARD nella stesura dei report dei loro studi. I revisori possono utilizzare la checklist per verificare che il manoscritto riporti tutte le informazioni essenziali e suggerire modifiche se mancano item fondamentali.

Le riviste che hanno supportato lo STARD sin dal 2003 dovrebbero raccomandare l’utilizzo di questa versione aggiornata e incoraggiare l’aderenza dei manoscritti, sperando che anche altre riviste ed editori promuovano STARD e altre linee guida per il reporting. Finanziatori e istituti di ricerca possono promuovere o rendere obbligatoria l’aderenza a STARD per massimizzare il value della ricerca diagnostica e i prodotti di letteratura secondaria correlati.

STARD può essere utile anche per il reporting di altri studi che valutano la performance dei test diagnostici: studi prognostici, che possono classificare i pazienti in relazione a un evento futuro; studi di monitoraggio, nei quali si suppone che i test diagnostici individuino o siano predittivi di un evento avverso o della mancata risposta terapeutica, studi di valutazione di marcatori per la scelta della terapia, etc. Tuttavia, se la maggior parte degli item dello STARD può essere utilizzata per il reporting di questi studi, la checklist è destinata principalmente agli studi di accuratezza diagnostica.

L’accuratezza diagnostica non è l’unica misura della performance di un test, né necessariamente la più significativa (12). Ad esempio, l’accuratezza incrementale legata alla combinazione di test può essere più informativa di quella relativa a un singolo test (13). Per i test misurati con variabili continue, la dicotomizzazione positivo/negativo non è sempre indicata; in questi casi, i metodi di calcolo e grafici più adeguati per esprimere la performance del test sono differenti, anche se molte delle precauzioni metodologiche potrebbero essere le stesse e STARD può migliorare l’informatività del report dello studio. Altre linee guida per il reporting individuano categorie di test più specifiche, come TRIPOD (Transparent Reporting of a Multivariable Prediction Model for Individual Prognosis or Diagnosis) per i modelli di previsione multivariati (14).

Anche se STARD si focalizza sul reporting integrale degli studi di accuratezza diagnostica, i suoi item possono essere utili per la stesura di protocolli di studio, di abstract destinati a conferenze e per le informazioni da inserire nei registri di trial. Ulteriori iniziative sono in corso per fornire indicazioni più specifiche per ciascuna di queste applicazioni.

Estensioni e applicazioni di STARD 2015

STARD 2015 è stato progettato per essere applicato a tutti i test diagnostici. Al fine di una maggiore diffusione e accettazione da parte di autori, revisori e direttori di riviste, il gruppo STARD ha preferito una checklist unica per tutti gli studi di accuratezza diagnostica, rispetto a checklist differenti per tipologie diverse di test (imaging, biochimica, istopatologia).

Ovviamente, una checklist generica può richiedere ulteriori istruzioni per il reporting, con maggiori informazioni rispetto a specifici test, specifiche applicazioni o tipologie di analisi. Ad esempio, queste indicazioni potrebbero descrivere i metodi preferiti per lo studio e il reporting della misura di incertezza, senza modificare gli altri item della checklist. Il gruppo STARD approva lo sviluppo di queste estensioni e invita i gruppi interessati a contattare il comitato direttivo prima di svilupparli.

Analogamente, è possibile sviluppare ulteriori linee guida per facilitare l’uso di STARD in specifiche applicazioni, quali la raccolta dell’anamnesi e dell’esame obiettivo (15), oppure in specifiche condizioni target quali la demenza (16).

Disponibilità

La checklist STARD 2015 e tutti i documenti correlati sono disponibili sul sito web di EQUATOR, iniziativa internazionale finalizzata ad aumentare il value della ricerca, promuovendo un reporting trasparente e completo e diffondendo l’utilizzo di rigorose linee guida per il reporting (17,18). Il gruppo STARD ritiene che una più stretta collaborazione con EQUATOR ed altri autori di linee guida per il reporting faciliterà il raggiungimento di obiettivi condivisi. Sul sito web di EQUATOR è disponibile anche l’aggiornamento del documento di spiegazione ed elaborazione del 2003, che fornisce per ciascun item razionale ed esempi.

La checklist STARD è pubblicata con licenza Creative Commons che permette a tutti di utilizzare e distribuire il lavoro, citando la fonte originale. La versione originale dello STARD 2015 è in lingua inglese, ma numerosi gruppi hanno già realizzato traduzioni in altre lingue. Il gruppo STARD approva queste traduzioni, preferibilmente realizzate da gruppi di ricercatori attraverso un processo di sviluppo ciclico, con back-translation in lingua originale e test pilota (19). STARD è un marchio registrato e il comitato direttivo mantiene il diritto esclusivo di utilizzare il termine “STARD” per identificare prodotti o servizi.

Aumentare il value, ridurre gli sprechi

Il comitato direttivo è consapevole che una lista di item essenziali non è sufficiente per ottenere miglioramenti sostanziali nella completezza del reporting, come dimostrano i modesti risultati ottenuti dopo l’introduzione della prima versione della checklist nel 2003. Di fatto, la checklist rappresenta il punto di partenza per costruire strumenti più specifici, basati sulla lista di item essenziali dello STARD, finalizzati a promuovere un reporting più completo e trasparente: una lista di controllo e uno strumento per supportare gli autori nella stesura del manoscritto, strumenti per revisori e direttori di riviste, video e materiali didattici.

Il reporting incompleto è stato identificato come una delle fonti di spreco evitabile nella ricerca biomedica1. Dalla nascita di STARD, numerose iniziative sono state intraprese per migliorare la riproducibilità della ricerca e promuoverne una maggiore trasparenza (20). L’augurio è che l’aggiornamento e l’implementazione dello STARD, aiuti autori, direttori di riviste, revisori, lettori e decisori a raccogliere, valutare e applicare le evidenze necessarie a rafforzare decisioni e raccomandazioni sui test diagnostici. Tutti possono trarre beneficio da un reporting più informativo e trasparente della ricerca: ricercatori, professionisti sanitari, cittadini e pazienti.

Strumenti

Contributo degli Autori

Tutti gli autori confermano di aver contribuito al contenuto intellettuale di questo articolo e soddisfano i seguenti requisiti: (a) contributi significativi all’ideazione e al disegno, acquisizione dei dati o analisi e interpretazione dei dati; (b) stesura o revisione dei contenuti intellettuali dell’articolo; e (c) approvazione finale dell’articolo pubblicato.Disclosure dei conflitti di interesse

Tutti gli autori hanno sottoscritto la disclosure per i conflitti di interesse prevista dalla rivista Clinical Chemistry: Rifai N lavora per Clinical Chemistry, AACC; Gatsonis CA è membro del RSNA Research Development Committee.Indirizzo per la corrispondenza

p.m.bossuyt@amc.uva.nlProvenienza

Tradotto da: Bossuyt PM, Reitsma JB, Bruns DE, et al. STARD 2015: an updated list of essential items for reporting diagnostic accuracy studies. BMJ 2015;351:h5527Questo articolo è stato pubblicato contemporaneamente nell’ottobre 2015 su BMJ, Radiology e Clinical Chemistry con licenza Creative Commons CC BY-NC: http://creativecommons.org/licenses/by-nc/4.0.

Fonti di finanziamento

Nessun finanziamento esplicito per lo sviluppo di STARD 2015. L’ Academic Medical Center dell’Università di Amsterdam (Paesi Bassi) ha finanziato in parte il meeting del comitato direttivo STARD senza influenzare sviluppo e disseminazione della checklist. I membri del comitato direttivo STARD e i membri del gruppo STARD hanno sostenuto personalmente i costi.Approvazione comitato etico

-Ringraziamenti

Note alla versione italiana

La Fondazione GIMBE ha sostenuto la traduzione italiana dell’articolo senza alcun supporto istituzionale o commerciale.

Team che ha realizzato la versione italiana

Responsabile scientifico

Antonino Cartabellotta, Fondazione GIMBE

Coordinamento editoriale

Marco Mosti, Fondazione GIMBE

Traduzione

Elisa Esposito, Palermo

Federica Riccio, Specialista in Igiene e Medicina Preventiva. Casale Monferrato (AL)

Revisione editoriale

Elena Cottafava, Fondazione GIMBE

Roberto Luceri, Fondazione GIMBE

Pagina aggiornata il 26/gennaio/2016